BenchLLMとは何ですか?

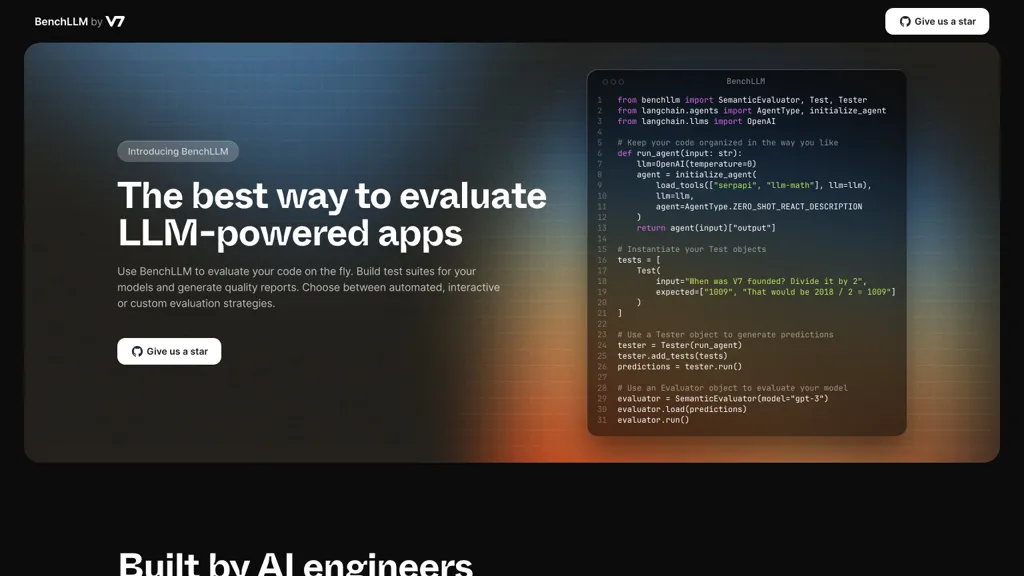

BenchLLMは、様々な方法でLLM(大規模言語モデル)を活用したアプリを評価するための強力なAIツールです。BenchLLMを使用することで、自動、インタラクティブ、カスタムの評価戦略から選択し、簡単に質の高い報告書を生成できます。

また、semanticevaluator、test、testerオブジェクトをインポートしたり、OpenAI、langchain.agents、およびlangchain.llmsを使用してモデルの評価を行うことも可能です。BenchLLMを利用すると、簡単で洗練されたCLIコマンドを使用して、コードを整理し、テストを実行することができます。

本番環境でモデルのパフォーマンスを監視し、回帰を容易に検出することもできます。OpenAI、langchain、api boxをサポートすることで、BenchLLMは多様なLLMを活用したアプリの評価に使用可能な万能ツールです。

AIエンジニアであれ、AI製品を開発するチームの一員であれ、BenchLLMはモデルの正確性と信頼性を確保するための完璧なツールです。直感的なインターフェースと複数の評価戦略をサポートしており、テストを簡単に定義し、LLMを活用したアプリに関する情報に基づいた意思決定を支援する洞察に富んだ報告書を生成できます。

⭐ 主な機能

BenchLLMのコア機能と利点は以下の通りです:

⚙️ ケーススタディとアプリケーション

- ✔️ テストを実施し、洞察に富んだ報告書を生成することで、LLMを活用したアプリの正確性と信頼性を確保します。

- ✔️ BenchLLMを使用して、簡潔で洗練されたCLIコマンドでコードを整理し、テストを実行します。

- ✔️ BenchLLMを使用して、本番環境でモデルのパフォーマンスを監視し、容易に回帰を検出します。

🙋♂️ 対象ユーザー

BenchLLMは以下のユーザーグループに役立ちます:

ソフトウェア開発者

QAエンジニア

プロダクトマネージャー

データサイエンティスト

ℹ️ 詳細とサポート

BenchLLMは、開発者がプログラム的にアクセスできるAPIを提供しており、他のツールや独自のアプリケーションとの統合が容易です。

さらに、詳細情報を調べたり、サポートを受けたり、以下のチャネルでBenchLLMの更新をフォローできます:

- BenchLLMウェブサイト(ログイン/サインアップ)